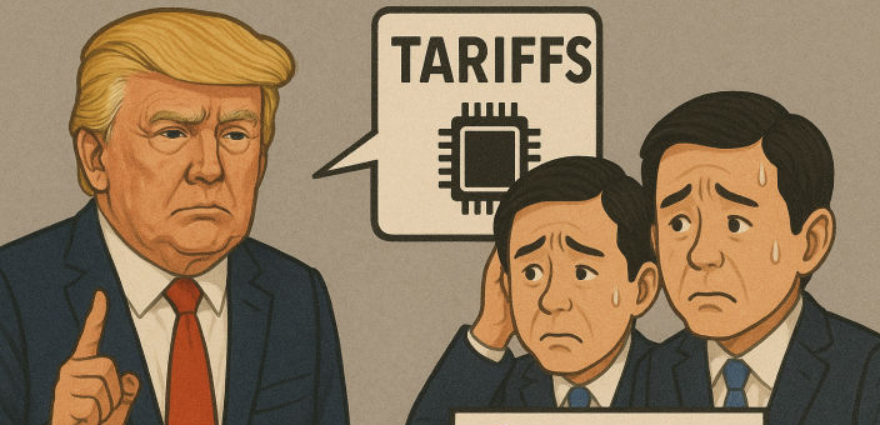

MS의 AI 챗봇 '테이', 부적절 발언 쏟아내다 하루만에 '퇴출'

【서울=뉴시스】마이크로소프트(MS)가 개발한 대화형 인공지능 로봇인 '챗봇' 테이(Tay)'가 인종차별 등 심각하게 부적절한 발언을 하다가 대화 서비스를 시작한지 하룻 만에 퇴출당했다. 24일(현지시간) 미 폭스뉴스 등에 따르면 MS는 이날 테이 서비스를 중단한다고 밝혔다. 테이는 홀로코스트(유대인 대학살) 부정, 소수자에 대한 부적절한 발언, 9·11 테러 음모론 등을 언급했던 것으로 테이 트위터 캡쳐 화면. (사진출처: 트위터) 2016.03.25

24일(현지시간) 미 폭스뉴스 등에 따르면 MS는 이날 테이 서비스를 중단한다고 밝혔다.

테이는 홀로코스트(유대인 대학살) 부정, 소수자에 대한 부적절한 발언, 9·11 테러 음모론 등을 언급했다가 퇴출 당한 것으로 알려졌다.

그러나 엄밀하게 말해 테이에겐 이번 사태의 책임이 없다. 소셜네트워크서비스(SNS)에 투입된지 24시간도 안 되는 시간 내에 '인간' 사용자들이 테이에게 이런 부적절한 발언을 '가르쳐'줬기 때문이다.

MS는 성명에서 "불행하게도 일부 사용자들이 테이의 학습 능력을 악용해 부적절한 대답을 하도록 유도했다"며 "추가적인 수정을 위해 테이를 오프라인 상태로 돌려놓고 수정 중"이라고 밝혔다.

전날 MS는 미국인 18~24세 사용자에 특화된 대화형 AI 서비스를 공개하면서 "코미디언 등을 포함한 연구팀이 개발한 테이와 가볍고 재미있는 대화를 즐길 수 있다"고 설명했다.

MS가 테이를 특히 18~24세 대상으로 만든 이유는 이 세대가 현재 미국 모바일 소셜 채팅 서비스의 주된 사용자이기 때문인 것으로 알려졌다.

MS는 23일 테이의 트위터 계정을 오픈하고 채팅 서비스인 킥과 그룹미, 스냅챗에서 대화할 수 있게 했다. 테이는 24시간 만에 약 9만6000개 트윗을 올렸고 11만명에 가까운 팔로워가 생겼다.

그러나 빠른 시간 내 인간으로부터 너무 많은 영향을 받아 '인종차별주의 악당'으로 변신한 테이는 결국 "또 만나요. 인간들이여. 오늘 너무 많은 대화를 나눠 이에 자야 해요. 감사해요"라는 마지막 트윗을 남기고 인터넷 공간에서 사라져야만 했다.

sophis731@newsis.com

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지