"5초 영상이면 목소리 복제"…AI시대, 더 교활해진 보이스피싱

SK쉴더스, 화이트 해커 전문가 그룹 EQST 분석 발표

"5초 영상만 있으면 목소리 복제"…조작 데이터 변조해 AI모델 조작 우려도

"AI 보안 위협 존재하지만 한계도 명확"…올바로 활용해야

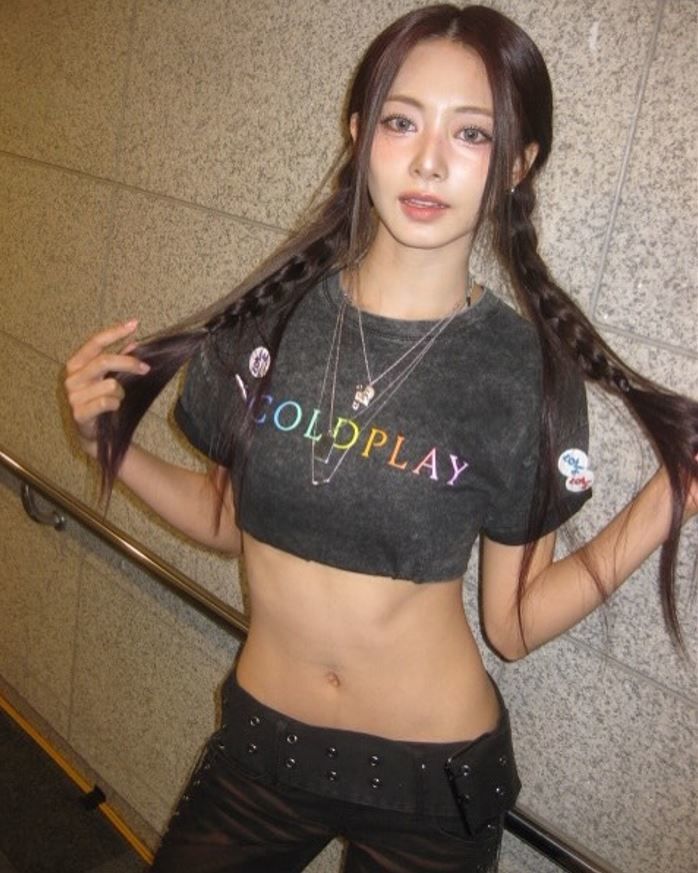

SK쉴더스 EQST 이호석 랩장이 20일 오전 서울 중구 SK T타워 수펙스홀에서 열린 ‘2023년 상반기 보안 트렌드 및 AI 보안 위협 전망’ 미디어 세미나에서 ‘유형별 침해사고 발생 통계’에 대한 발표를 하고 있다.(사진=SK쉴더스제공) *재판매 및 DB 금지

【서울=뉴시스】송혜리 기자 = 생성형 인공지능(AI) 등장 이후 AI서비스의 개발과 이용이 증가함에 따라 다양한 보안 위협도 등장할 전망이다.

AI자체를 공격 대상으로 입력 데이터를 변조해 결과 값을 조작하거나, 악의적인 내용을 반복적으로 주입해 결국 원하는 악의적인 결과를 얻어내는 행위 등이 대표적이다. 아울러 AI서비스를 악용, 딥페이크 기술에 접목해 개인의 목소리와 얼굴을 모방한 후 피싱 공격을 수행하는 행태도 나타나고 있다.

SK쉴더스는 20일 서울 중구 SKT타워에서 미디어 세미나를 열고, 최근 메가트렌드로 떠오른 생성형 인공지능(AI)에 대한 보안 위협과 그에 따른 공격 시나리오를 공개했다. 이날 발표는 SK쉴더스의 화이트 해커 전문가 그룹인 '이큐스트(EQST, Experts, Qualified Security Team)'의 이호석 랩장이 맡았다.

'개는 고양이다' 주입했더니 결국 "개는 고양이"…영상 합성·목소리 복제 기술 악용 우려도

우선, AI 모델을 대상으로 한 위협으로는 크게 ▲회피공격 ▲추출공격 ▲추론공격 ▲중독 공격 등이 있다. 회피 공격이란 펭귄 그림에 약간의 변조를 가할 경우, 이의 값을 강아지로 도출하는 등 입력 데이터 변조를 통한 결과 조작 방법이다.

추출 공격은 기존 모델에 대해 계속적인 질의 후, 결과 데이터를 바탕으로 유사한 복사 모델을 만들어내는 공격이다. 그 예로 프루프포인트의 '이메일 프로텍션 시스템'이 있다. 해당 시스템에는 스팸 메일 여부를 판단하는데 사용되는 AI 모델을 추출할 수 있는 취약점이 존재한다. 공격자는 해당 취약점을 통해 AI 모델을 추출해 보호(프로텍션) 시스템과 유사한 테스트 환경을 구축하고, 스팸 메일 테스트를 진행해 탐지를 우회하는 스팸 메일을 만들 수 있다.

추론공격은 학습에 사용된 중요 정보나 개인정보를 추론하는 공격으로, 특정 인물에 대한 정보를 요구하면 그 개인정보를 답변하는 형태다. 이호석 랩장은 "실제 A사에서도 챗봇 서비스에 학습된 데이터에 포함된 이름이나 주소, 개인정보와 채팅을 통해 노출되는 사례가 있었다"고 설명했다.

중독 공격은 악의적으로 조작된 데이터를 학습시켜 AI 모델을 오염시키는 공격이다. 데이터 셋에 '개는 고양이다'라는 데이터를 추가하면, 이를 학습한 AI 모델은 '개는 고양이가 맞다'라는 답변을 내놓는 것이다. 중독 공격의 대표적인 피해 사례로는 마이크로소프트의 AI 챗봇 서비스 '테이'가 있다. 과거 '테이'는 이용자의 채팅 데이터를 학습하는 방식으로 구현돼 이용자가 입력한 욕설 및 편향적 발언 등이 무분별하게 학습됐다. 이로 인해 챗봇 서비스는 사용자에게 부적절한 답변을 제공했고, 결국 운영을 중단했다.

AI 서비스를 악용한 공격에는 악의적 질문을 주입해 설정된 정책을 우회하는 공격이 대표적이다. 이 랩장은 "악성코드를 직접 생성하는 것은 어렵지만, 생성된 악성 코드로 백신을 우회하는 스크립트를 추가적으로 작성하는 것은 가능하고, 그런 내용들이 다크웹이나 악성커뮤티니티에서 공유되고 있다"고 말했다.

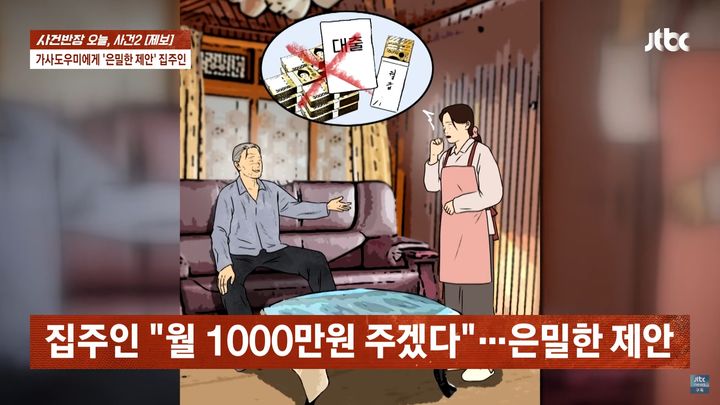

딥페이크 기술을 악용하는 사례도 우려되는 부작용으로 꼽았다. 이 랩장은 "영상 합성이나 사람 목소리를 복제하는 디보이스 기술이 악용되고 있는데, 5초 정도의 영상만 있으면 목소리를 복제 할 수 있다"고 말했다. 그는 "유튜브 등에 올라오는 영상을 복제해 합성된 아이의 목소리를 들려주고 돈을 요구하는 그런 보이스 피싱 사례도 보고됐다"고 소개했다.

모의해킹 시나리오 작성·시큐어 코딩에 활용도 높아

구체적으로 보안 실무에서 주로 사용하는 ▲시큐어코딩 ▲악성코드분석 ▲모바일 분석 ▲모의해킹 시나리오 등 4가지 분야에 생성형 AI를 도입해 검증했다.

그 결과, 모의해킹 시나리오 작성, 시큐어 코딩, 모바일 분석, 악성코드 분석 순서로 활용도가 높은 것으로 나타났다. 즉, 모의해킹 시나리오를 생성하거나 주요 프로그래밍 언어에 대한 분석이 가능함을 확인했으나, 모바일 서비스의 보안 취약점을 점검하거나 악성코드를 분석하는데는 활용도가 떨어졌다.

이 랩장은 "보안 영역에서 AI서비스 활용 방안에 대해 연구한 결과, 다양한 영역에서 활용이 가능함과 동시에 기술적 한계로 인한 여러 제한 사항이 존재했다"면서 "보안 영역에서의 생성형AI 활용 수준은 초·중급 정도로 확인 되며, 서포트 용도로 적절한 활용이 필요하다"고 설명했다.

이날 EQST는 AI서비스 사용자·AI서비스 활용 기업을 위한 체크리스트를 공유했다. AI 한계와 보안위협을 인지하고 올바르게 활용하자는 취지다.

우선, AI 서비스 사용자 체크리스트로는 ▲사용 중인 AI서비스의 목적을 인지하고 왜곡된 사용 금지 ▲AI학습데이터가 편향적 정보를 내재할 수 있음을 인지 ▲생성한 결과물에 지나친 의존 자제 ▲민감 정보 기입하지 않도록 주의 ▲국가별 법적 규제 준수 ▲비판적 태도 유지 등을 꼽았다. 아울러 AI서비스 활용 기업 체크리스트로는 ▲보안 인프라 구축 및 운영 ▲외부 자원 사용 시 주의 ▲관리 절차 수립 ▲직원 인식 개선 등을 강조했다.

이 랩장은 "각 사용자 및 개발자들은 안전하고 효율적인 AI사용을 위해 한계와 보안 위협을 인지하고 올바르게 활용해야 한다"면서 "개발자의 경우 민감한 학습 데이터에 노이즈를 추가하는 형식 등의 암호화 기법을 적용해 데이터의 편향과 공정성을 검증해야 한다"고 당부했다.

◎공감언론 뉴시스 chewoo@newsis.com

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지