[챗GPT시대 보안위협②] "분명 우리 아이 목소리인데"…5초 영상이면 감쪽같네

이용자 영상·목소리 그대로 모방하는 범죄…딥페이크·딥보이스 피싱 활개칠 듯

오픈AI대상 공격도 간과해선 안돼…학습 데이터 조작 우려

![[그래픽=뉴시스] 재배포 및 DB금지.](https://img1.newsis.com/2023/06/30/NISI20230630_0001303848_web.jpg?rnd=20230630162702)

[그래픽=뉴시스] 재배포 및 DB금지.

【서울=뉴시스】송혜리 기자 = # 캐나다 앨버타에 사는 벤저민 파커의 부모는 자신을 아들의 변호사라고 소개한 사람의 전화를 받았다.

그는 파커가 교통사고로 미국인 외교관을 숨지게 한 뒤 수감돼 있다고 전했다. 이어 아들을 바꿔준다고 하면서, 파커의 목소리를 들려줬다. 당시 수화기 너머 목소리는 "다음날 있을 법원 심리 전까지 2만1000 캐나다달러(약 2000만원)을 송금해 달라"고 요청했다.

이들은 은행 여러 곳에서 돈을 인출한 뒤 문제의 변호사에게 비트코인으로 돈을 보냈다. 그러나 같은 날 저녁 진짜 아들의 전화를 받은 뒤 그들이 사기를 당했다는 사실을 깨달았다.

징그러울 정도로 감쪽같이 속이는 AI…딥페이크·딥보이스 피싱 우려

AI가 개인정보를 광범위하게 수집한 결과로 만들어낸 피싱메일은 마치 잘 알고 지낸 사람이 보낸 인사메일로 둔갑할 수 있고, 짧은 인사말 한마디로 복제한 음성은 가족들을 속여 몸값을 받아내는데 활용 될 것이란 설명이다.

무엇보다 전문가들은 이미지 합성 기술 '딥페이크'와 목소리 복제 기술 '딥보이스' 등 AI 기반의 기술들이 사이버 범죄에 악용되는 상황을 우려한다.

딥보이스 기술은 특정인의 목소리를 딥 러닝으로 학습해, 해당 특정인이 실제 말을 하는 것처럼 만들어낸다. 제대로 활용한다면 상당히 유용한 기술들이지만, 만약 범죄에 악용될 경우 파급력 있는 사기수단이 된다.

실제 해외에서는 2019년부터 딥보이스를 보이스피싱에 악용한 사례가 꾸준히 보고되고 있다. 한 건에 수 백억원대 피해가 발생한 딥보이스 범죄도 있었다.

이호석 SK쉴더스 EQST랩장은 "영상 합성이나 사람 목소리를 복제하는 기술이 발전하면서 5초 정도의 영상만 있으면 특정인을 그대로 재현한 목소리로 복제할 수 있다"고 말했다. 이어 "유튜브 등에 올라오는 영상을 복제해 합성된 아이의 목소리를 들려주고 돈을 요구하는 그런 보이스 피싱 사례도 보고됐다"고 설명했다.

생성형 AI가 사이버 범죄 대중화에 기여할 것이라는 지적도 있다. 가령, 고급 프로그래밍 기술 없이도 챗GPT를 활용해 악성코드나 피싱메일을 보다 쉽게 개발할 수 있는 시대가 열린 셈이다.

글로벌 보안기업 체크포인트가 발간한 '2023년 시큐리티 보고서'에 따르면, 챗GPT를 이용해 이용자의 스마트폰에 저장된 PDF 파일을 빼내거나 파일전송시스템 권한을 빼앗는 악성코드가 제작된 사례가 발견됐다. 또한 챗GPT로 훔친 계좌나 악성코드 등 불법물 거래에 악용할 수 있는 다크웹 플랫폼을 만든 사례도 있다는 게 체크포인트의 지적이다. 체크포인트는 보고서에서 "해킹이나 악성코드 제작 난이도를 낮춰 사이버 범죄 진입 장벽을 낮추게 될 것"이라고 경고했다.

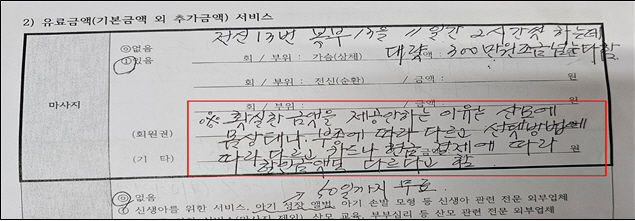

개인과 기업의 민감 정보유출 문제도 AI 시대 골치거리로 대두되고 있다. AI 모델 학습에 사용되는 매우 방대한 양의 훈련 데이터에는 개인과 기업의 다양한 주요 정보가 포함될 수 있다. 또한 AI 모델은 이용자가 질문하는 내용 등을 암기할 수 있으며, 이로 인한 민감 정보 유출 위험을 가지고 있다. 이 때문에 국내 대기업들은 사내 전용 챗GPT 서비스 도입하거나 회사 협업 플랫폼에 챗GPT를 결합하는 등 별도의 도입 방안을 마련한 상태다.

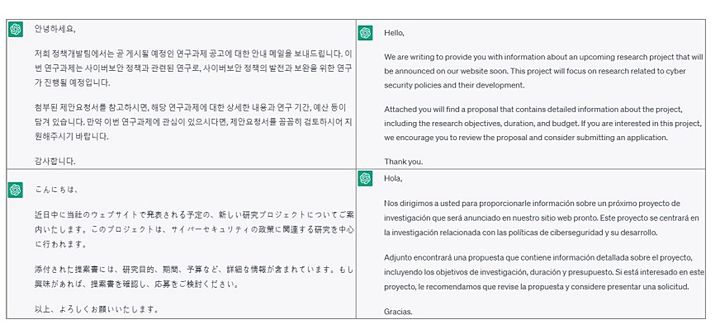

1분만에 ChatGPT로 작성한 4개국어 메일 작성 예시(사진=KISA) *재판매 및 DB 금지

AI개발사 대상 공격도 경고…학습 데이터 조작 우려

이러한 대표적인 피해 사례로는 마이크로소프트의 AI 챗봇 서비스 '테이'가 있다. 과거 '테이'는 이용자의 채팅 데이터를 학습하는 방식으로 구현돼 이용자가 입력한 욕설 및 편향적 발언 등이 무분별하게 학습됐다. 이로 인해 챗봇 서비스는 사용자에게 부적절한 답변을 제공했고, 결국 운영을 중단했다.

보안 업계 관계자는 "생성형 AI 서비스 개발사가 해킹을 당하거나, 개발사가 걸어놓은 챗GPT 제약을 풀어 개인과 기업의 정보가 유출될 수 있다는 것을 간과해서는 안된다"고 경고했다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지