'터미네이터 vs 아이언맨'…오픈AI 사태의 교훈

샘 올트먼 해고·복귀 한편의 드라마 …'영리 우선' VS '인류 공존' 헤게모니 다툼

AI 윤리 문제 전면 이슈화…네이버·카카오는 어떨까

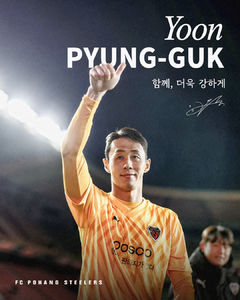

![[뉴시스]샘 올트먼이 자신의 엑스(X·전 트위터) 계정에 올린 사진. (사진=엑스 캡처) 2023.11.20 *재판매 및 DB 금지](https://img1.newsis.com/2023/11/20/NISI20231120_0001416416_web.jpg?rnd=20231120120054)

[뉴시스]샘 올트먼이 자신의 엑스(X·전 트위터) 계정에 올린 사진. (사진=엑스 캡처) 2023.11.20 *재판매 및 DB 금지

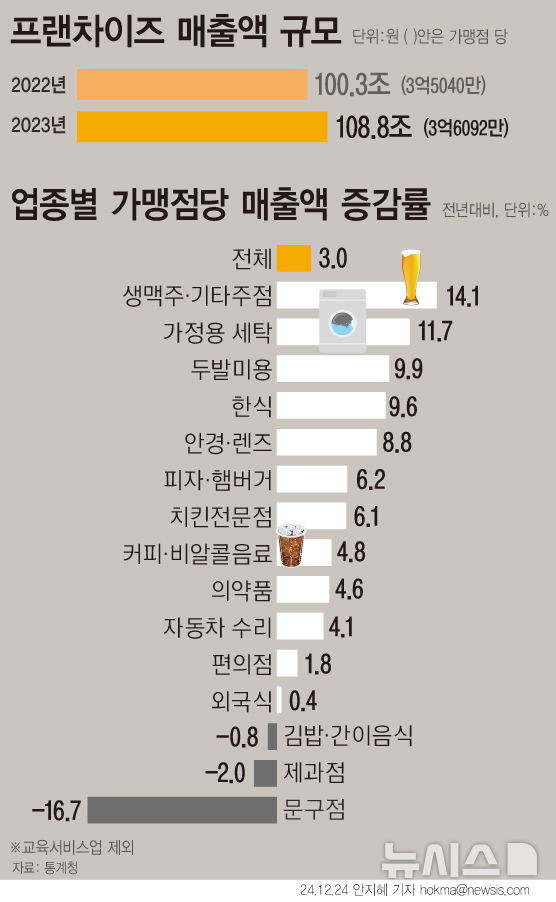

'챗GPT 아버지' 샘 올트먼의 오픈AI 해고부터 복귀까지 닷새간 펼쳐진 촌극은 인공지능(AI) 개발 윤리의 중요성을 깨닫는 사건으로 기록됐다. 이는 우리나라의 대표적인 AI 기술 기업 네이버와 카카오의 AI 개발 원칙을 돌이켜보는 계기가 됐다. 네이버와 카카오 역시 AI 윤리 준칙을 제정하고 대중을 위한 AI 서비스를 개발 중이다.

전 세계서 가장 뜨거운 AI 스타트업 '오픈AI'의 이념적 갈등

오픈AI 공동 창업자 두 사람인 올트먼을 해고하고 그렉 브록먼을 사임하게 한 오픈AI 이사회 멤버 중에는 인류에 안전한 AI 개발을 우선시하는 입장의 일리야 수츠케버와 헬렌 토너 등이 속해 있었다.

오픈AI의 또 다른 공동 창업자이자 수석 과학자인 수츠케버는 '딥러닝의 창시자' 'AI 대부'로 불리는 영국 컴퓨터 과학자 제프리 힌튼의 수제자다. 힌튼은 "성급한 AI 기술 개발이 인류에 악영향을 미칠 수 있다"며 AI 기술의 위험성을 경고해온 신중론자다. 수츠케버 역시 그와 같은 입장이다.

조지타운대학교 보안·신기술 센터의 토너 역시 AI가 너무 강력해지면 인류를 위협할 수 있다고 경고해온 인물로, 올트먼과 AI의 미래에 대한 이념이 달라 갈등을 빚어온 것으로 전해진다. 지난 10월 발표된 공동 집필 논문에서 챗GPT 및 GPT-4 출시와 관련한 안전·윤리 문제를 지적한 바 있다.

오픈AI가 올트먼 해임 직후 블로그에 "인류를 해치거나 권력을 과도하게 집중시키는 AI 또는 일반인공지능(AGI)을 활성화하는 것을 피하고, AGI를 안전하게 만드는 데 필요한 연구를 수행해야 한다"는 글이 올렸을 때, 이번 사태의 원인을 가늠할 수 있었다.

오픈AI 공동 창업 멤버였던 일론 머스크 테슬라 CEO도 소셜 미디어 엑스(X)에서 수츠케버에게 "왜 그런(올트먼 해고) 과감한 행동을 취했느냐"며 "만약 오픈AI가 잠재적으로 인류에 위험한 뭔가를 하고 있다면, 세상이 알아야 한다"고 우려했다.

그러나 올트먼 축출에 찬성했던 수츠케버와 토너 등 이사회 멤버는 오픈AI의 직원들과 투자자들의 압박을 버티지 못했다. 먼저 수츠케버가 "이사회의 행동에 참여한 것을 깊이 후회한다"며 입장을 번복했고, 토너는 "이제 우리 모두 잠을 잘 수 있게 됐다"며 오픈AI 이사회를 떠났다.

이번 사태로 오픈AI는 올트먼의 복귀를 도운 마이크로소프트(MS)와 보다 견고한 동맹 관계를 구축하게 됐다. 비영리 재단에서 출발했던 오픈AI가 최대 투자사인 MS와 함께 본격적인 수익화 사업에 나설 것으로 전망된다. MS는 새롭게 출발하는 오픈AI 이사회 멤버에 들어가길 원하는 것으로 알려졌다.

올트먼은 "오픈AI로 돌아와 MS와의 강력한 파트너십을 구축할 수 있기를 기대한다"고 말했다. 나델라 역시 "오픈AI 이사회의 변화에 고무돼 있다"며 "이번 결정이 보다 안정적이고 충분한 정보를 바탕으로 효과적인 거버넌스를 향한 첫 번째 필수 단계라고 믿는다"고 전했다.

오픈AI의 AI 사업화 및 수익화도 더욱 탄력받을 것으로 보인다. 올트먼은 AGI 모델인 GPT-5를 출시하겠다고 발표한 바 있다.

한국 대표 AI 기업, 네이버·카카오는?

![[서울=뉴시스] 인공지능(AI). (사진=뉴시스 DB). photo@newsis.com](https://img1.newsis.com/2023/11/10/NISI20231110_0001408993_web.jpg?rnd=20231110151051)

[서울=뉴시스] 인공지능(AI). (사진=뉴시스 DB). [email protected]

네이버는 지난 8월 자체 LLM '하이퍼클로바X'를 출시한 이후 생성 AI 챗봇 '클로바X', 생성 AI 기반 검색 서비스 '큐(Cue:)'를 선보였다. 카카오는 지난 7월 이미지 생성 AI '칼로2.0'을 선보였고, 자체 LLM '코GPT 2.0′을 연내 공개한다는 목표다.

코스피 상장사인 네이버와 카카오는 비영리 재단으로 출범한 오픈AI와 출발선 자체가 다르다. 대중에게 유익한 서비스를 제공하고 수익을 얻는 것이 이들의 사업 목적이다. 일반적인 영리 기업과 다르지 않다. 다만 이들도 LLM과 생성형 AI 서비스를 대중에게 공개할 때 AI 윤리 준칙을 따른다.

네이버는 지난 2021년 2월 모든 구성원이 AI 개발과 이용에 있어 준수해야 하는 AI 윤리 준칙을 발표했다. ①사람을 위한 AI 개발 ②다양성의 존중 ③합리적인 설명과 편리성의 조화 ④안전을 고려한 서비스 설계 ⑤프라이버시 보호와 정보 보안의 총 5개 조항으로 구성돼 있다.

지난 5월에는 초거대 AI 윤리 관련 논문을 발표했다. 이 논문은 세계 최고 권위 자연어처리(NLP) 학회(ACL 2023)에서 채택됐다. 연구에서 제안한 데이터셋은 초거대 AI를 만들거나, 이를 활용해 서비스를 운영하고 있는 전세계 많은 기업 및 연구 기관에서도 사용할 수 있도록 공개했다.

또 네이버는 서울대와 함께 초대규모 AI 관련 다양한 난제를 해결하기 위한 연구 협력을 진행 중이며, 최근 ‘신뢰성 있는 초거대 AI’를 중요한 아젠다로 삼았다. 가장 최근에는 영국 정부가 주최한 'AI 안전성 정상회의'에 참석해 AI의 잠재적 위험성을 논의하고, 글로벌 협력을 통해 AI의 잠재적 위험을 완화할 수 있는 방법을 모색했다.

네이버 관계자는 "네이버는 'AI 안전성', '지속가능한 AI'를 중요한 연구 주제로 보고 내부는 물론, 글로벌 유수 연구기관 및 기업들과 함께 AI 신뢰성, 안전성 관련 연구를 수행하고 있다"며 "결국 수익을 내기 위해서 많은 사용자들이 이용할 수 있게 하려면 안전성을 고려해야 하기 때문에 수익과 안전성은 떼어 놓을 수 없는 가치"라고 말했다.

카카오는 2018년 1월 '카카오 알고리즘 윤리헌장'을 발표했다. 인류의 편익과 행복을 추구하는 카카오 AI 기술의 지향점, 의도적 차별성 방지, 윤리에 근거한 학습 데이터 및 수집 관리 원칙, 알고리즘 관리의 독립성과 알고리즘에 대한 설명 방침 등이 담겨 있다.

2022년 7월에는 카카오 공동체얼라인먼트센터(CAC)가 공동체 전반에 걸쳐 기술 윤리를 점검하고 이를 사회와 함께 발전시켜 나가는 방안을 지속적으로 연구하기 위한 ‘카카오 공동체 기술윤리위원회(Tech for good committee)’를 새롭게 신설했다. 카카오 공동체 서비스들의 AI 윤리규정 준수 여부와 위험성 점검, 알고리즘 투명성 강화 등을 위한 체계적 정책 개선 업무를 수행한다.

◎공감언론 뉴시스 [email protected]

Copyright © NEWSIS.COM, 무단 전재 및 재배포 금지